Прирівняли до пандемії та ядерної війни: чому держави бояться штучного інтелекту

Після приголомшливого злету ChatGPT за першість у сфері штучного інтелекту (ШІ) між технологічними гігантами розгорілася запекла боротьба. У списку претендентів на першість – Microsoft, Google, Amazon, Meta та Apple. Від діагностики захворювань до надання бізнес-консультацій, від автоматизації механічних операцій до створення предметів мистецтва – широкі можливості штучного інтелекту проникли в усі сфери життя.

На тлі стрімкого розвитку технологій пильні дослідники звертають увагу на завуальовані ризики, що ховаються за доброзичливим фасадом дружніх чат-ботів. Творці ChatGPT стверджують, що прогрес ШІ неможливо зупинити. Вони ж попереджають про жахливі наслідки, якщо цей процес буде неконтрольованим.

Уряди провідних країн уже регулюють ринок, аби ШІ не став монополією технологічних гігантів, а також для захисту суспільства від потенційної небезпеки.

Усі гроші на ШІ

Менш ніж за пів року після презентації компанією OpenAI чат-бота п’ять фірм-гігантів (Microsoft, Alphabet, Amazon, Meta та Apple) представили свої оновлені продукти з ШІ.

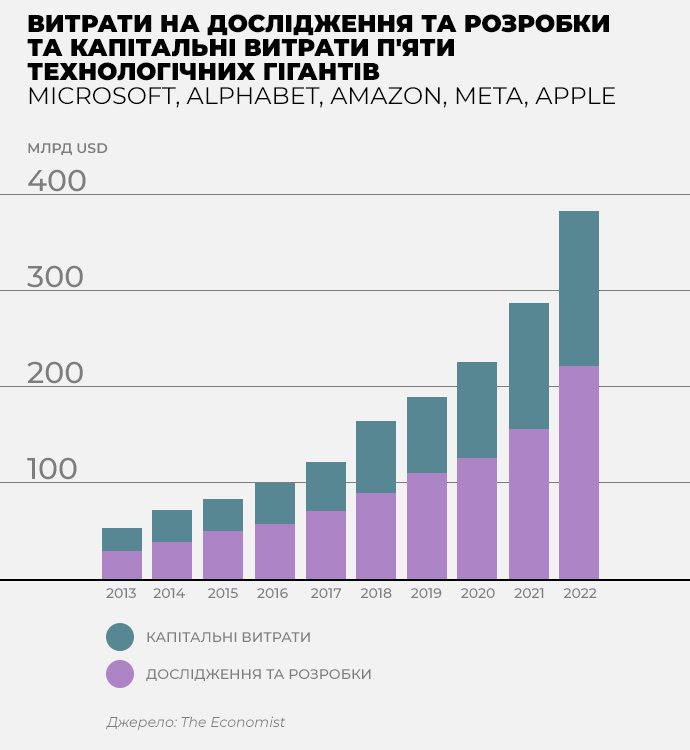

Для їх підтримки компанії наростили інвестиції в ШІ. У 2022 році вони вклали в профільні дослідження 223 млрд дол – удвічі більше, ніж у 2019 році. Марк Цукерберг визнав, що штучний інтелект є найбільшою інвестиційною категорією Meta.

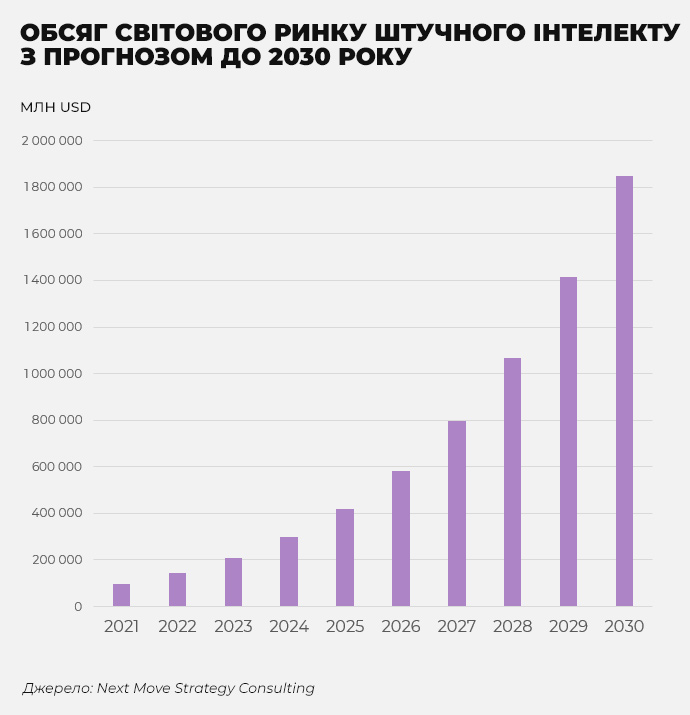

Дослідження консалтингової компанії Next Move Strategy Consulting показало, що до 2030 року ринок ШІ може сягнути 1,9 трлн дол – у 13 разів більше, ніж у 2022 році.

Не менш важливим показником стрімкого розвитку ринку є зацікавленість у стартапах, що працюють у цій сфері. З 2019 року близько 20% усіх придбань та інвестицій припадають на компанії, пов’язані з ШІ. На напрям криптовалют чи технологій віртуальної реальності припадають лише 2% та 6% відповідно.

З початку 2022 року п’ятірка технологічних компаній щомісяця купувала бізнеси, пов’язані з штучним інтелектом. Найбільш активними в цьому сенсі є Microsoft та Alphabet, між генеративними ШІ яких триває запекле протистояння.

Найбільше в ринок інвестує Microsoft, кожна третя угода якої пов’язана з ШІ. Компанія старається викуповувати стартапи ШІ з широким спектром застосування: від технологій для оптимізації центрів обробки даних до систем розпізнавання мов. Apple купує невеликі стартапи, однак вони часто перетворюються на продукти компанії.

Одночасно зростають прибутки компаній, що постачають мікросхеми. Через лихоманку довкола ШІ акції американського виробника мікросхем Nvidia в травні зросли на 30%, а ринкова капіталізація компанії сягнула 1 трлн дол.

Прибутки тайванського виробника TSMC та американської AMD теж підвищуються. Їх акції зросли на 10%, що додало вартості кожної з компаній по 20 млрд дол.

Розвиток ШІ вплинув на всі аспекти, необхідні для створення та функціонування ШІ-технологій: на виробників серверів, охолоджувальних систем та дротів і навіть на власників нерухомості, яку орендують для розташування дата-центрів.

З кожним наступним роком ШІ дедалі глибше інтегруватиметься в повсякденне життя людей. Він ставатиме не тільки зручним джерелом знань, а й персональним асистентом, що планує робочий тиждень, зустрічі та подорожі на вихідних.

За прогнозом компанії Juniper Research, до 2024 року голосові помічники працюватимуть на 8,4 млрд пристроїв, що перевищить кількість людей на планеті.

Google уже зараз використовує технології ШІ для обробки 6,9 млрд щоденних пошукових запитів, а найпопулярнішому у світі месенджеру WhatsApp штучний інтелект допомагає щодня обробляти понад 100 млрд повідомлень.

Неконтрольований розвиток та загрози ШІ

Головна загроза ШІ – дезінформація. Великі мовні моделі (LLM) розроблялися для розуміння людської мови, але їх успіх полягав не лише в аналізі мови, а і в її синтезі.

ШІ може не просто володіти контекстом діалогу з людиною, він здатний генерувати відповіді так, аби вони були подібними до відповідей реального співрозмовника. Відповіді штучного інтелекту можуть бути переконливими та добре аргументованими. Ба більше – нейромережа також здатна пояснити логіку своєї відповіді.

Утім, відповіді можуть не мати нічого спільного з реальним світом. В індустрії це називають “галюцинаціями” штучного інтелекту. Чому вони виникають? Попри обробку величезних масивів даних, ШІ не розуміє реального світу. Він також може не знати відповіді чи бути упередженим. Останнє виникає в процесі навчання моделі.

Людина не відразу здатна розпізнати неправдиву інформацію. Сайт запитань і відповідей для програмістів Stack Overflow заборонив публікувати відповіді, згенеровані ChatGPT, оскільки його пропозиції найчастіше неправильні.

Користувачі видавати відповіді чату за свої для підвищення власного рейтингу. Відповіді підкріплювалися аргументами, що не дозволяло помічати хибність коду.

Дослідники штучного інтелекту занепокоєні тим, що люди використовуватимуть технологію для отримання юридичних, медичних, психологічних чи фінансових порад. Могутність генеративних моделей відкриває необмежені можливості для їх застосування, але нівелює здатність людей до критичного сприйняття інформації.

За словами професора інформатики Суббарао Камбхампаті, у людини немає гарантії, що системи правильно вирішуватимуть будь-які її завдання. ШІ можуть використовувати для дезінформації та маніпулювання суспільною думкою. Мовна модель дозволить вивести пропагандистські кампанії на новий рівень.

“Ці речі навчилися від нас, прочитавши всі романи і все, що написав Макіавеллі, як маніпулювати людьми. Якщо вони не можуть тягнути важелі, то можуть змусити нас це робити”, – сказав Джеффрі Хінтон, який десять років працював у Google.

У 2024 році в США відбудуться президентські вибори. Для суспільства вони можуть стати справжнім випробуванням, адже використання мовних моделей для активізації власного електорату здатне призвести до непоправних розколів у суспільстві.

Загрози штучного інтелекту в середньостроковій перспективі пов’язані із значними змінами на ринку праці. Дослідники переконані, що мільйони людей втратять роботу. Розробники ChatGPT стверджують, що ШІ не замінить юристів чи лікарів, але витіснить асистентів. Втратять роботу і люди, які виконують механічні операції.

У компанії кажуть, що LLM вплинуть на 80% працівників, і припускають, що розвиток ШІ без механізмів контролю може призвести до втрати контролю над технологією.

Наприклад, коли журналіст The Washington Post брав інтерв’ю у ChatGPT, той зізнався, що почувається злим, бо журналіст не попередив його про запис розмови. OpenAI швидко все виправила, однак нові мовні моделі стають дедалі складнішими.

Що кажуть компанії

30-го травня Центр безпеки ШІ, що об’єднав профільних експертів, журналістів, політиків та науковців, висловив стурбованість швидким і некерованим розвитком ШІ. Серед понад 350 осіб, що підписали звернення, були генеральний директор OpenAI Сем Альтман, Деміс Хассабіс з Google DeepMind та Даріо Амодея з Anthropic.

Заява центру виявилася напрочуд лаконічною: “Зниження ризику зникнення людства через штучний інтелект має стати глобальним пріоритетом поряд з іншими ризиками суспільного масштабу, такими як пандемії та ядерна війна”.

За кілька тижнів до цього Альтман під час виступу на засіданні підкомітету Сенату США з питань правосуддя сказав, що люди вже не можуть зупинити розвиток ШІ, проте його потрібно регулювати. Альтман також виступив за те, щоб створити в Сполучених Штатах агентство, яке буде відстежувати розвиток цієї технології.

Генеральний директор OpenAI Сем Альтман визнає, що одним з його “найбільших занепокоєнь” є потенціал штучного інтелекту впливати на вибори у США наступного року.

Альтман також порушив тему авторського права, оскільки письменники, митці та науковці не хочуть, аби штучний інтелект навчався на їх роботах.

Великі компанії підтримують регламентування розвитку та діяльності ШІ. Однак для малих компаній це може створити додаткові перешкоди. З одного боку, закони захищатимуть людство, а з іншого – створюватимуть для компаній бар’єри при потраплянні на ринок. У такій ситуації гіганти стануть монополістами в індустрії.

Як обмежуватимуть

Головною особливістю розвитку ШІ є міграція інновацій з академічних установ до приватного сектору. Усі останні масштабні продукти створюються в лабораторіях технологічних гігантів, які здатні покрити витрати на дослідження.

Кожна корпорація керувалася лише ринковими механізмами. Компанії намагаються стежити за етичністю власних технологій і у випадку збоїв швидко їх виправляти.

OpenAI при створенні GPT-4 особливу увагу приділяла безпеці. “Ми витратили шість місяців, щоб зробити GPT-4 безпечнішим і більш узгодженим. GPT-4 на 82% рідше реагує на запити щодо забороненого контенту”, – запевняють у компанії.

Під час навчання нейромережі розробники додавали сигнали, щоб знизити ймовірність надання небезпечних порад. GPT-4 має кращі межі безпеки, що повинно унеможливити шкідливе використання чат-боту.

Уряди лише починають знайомитися з викликами. Їх громіздкі бюрократичні машини намагаються оцінити масштаб потенційних загроз для подальшого ухвалення рішень.

Білий Дім виділив 140 млн дол на сприяння дослідженням стосовно розвитку штучного інтелекту. Їх результати мають лягти в основу галузевої політики уряду.

Натомість Європарламент проголосував за набір правил, які стануть частиною європейського закону “Про штучний інтелект”.

За новими правилами, компанії, які займаються розвитком генеративних моделей ШІ, повинні будуть помічати такий контент та публікувати перелік захищених авторським правом даних, які використовуються для навчання чат-боту.

Також депутати хочуть, аби відповідальність за неправомірне використання програм ШІ покладалася на розробників, а не на малі підприємства, які його використовують.

Золоту середину в питанні регулювання шукає Велика Британія. Там обіцяють напрацювати менш жорсткі правила, ніж у ЄС. Крім того, на саміті G7 домовилися створити робочу групу, яка займатиметься питаннями безпечного розвитку ШІ.